Ollama(이하 올라마)가 2월 15일 윈도우에서 사용가능한 프리뷰 버전을 런칭했다.

올라마는 로컬에서 오픈소스 AI 모델들을 손쉽게 실행해줄 수 있는 프로젝트로 간편한 설치와 실행방식으로 구성된 점이 특징이다.

맥이나 리눅스는 괜찮지만 윈도우는 아직 프리뷰 버전이라 UI가 딱히 없이 파워쉘 환경에서의 명령어 형식이다.

그래도 오프라인 환경에서 LLM 모델을 자유롭게 사용할 수 있다는 점은 큰 장점이다!

거기다 최근 구글 제미나이가 발표되면서 젬마 오픈소스를 공개해준터라 해당 모델 사용을 위해 Ollama를 통한 윈도우 오프라인 구축을 실시했다.

1. Windows 설치 및 사용 (Preview)

1.1 설치

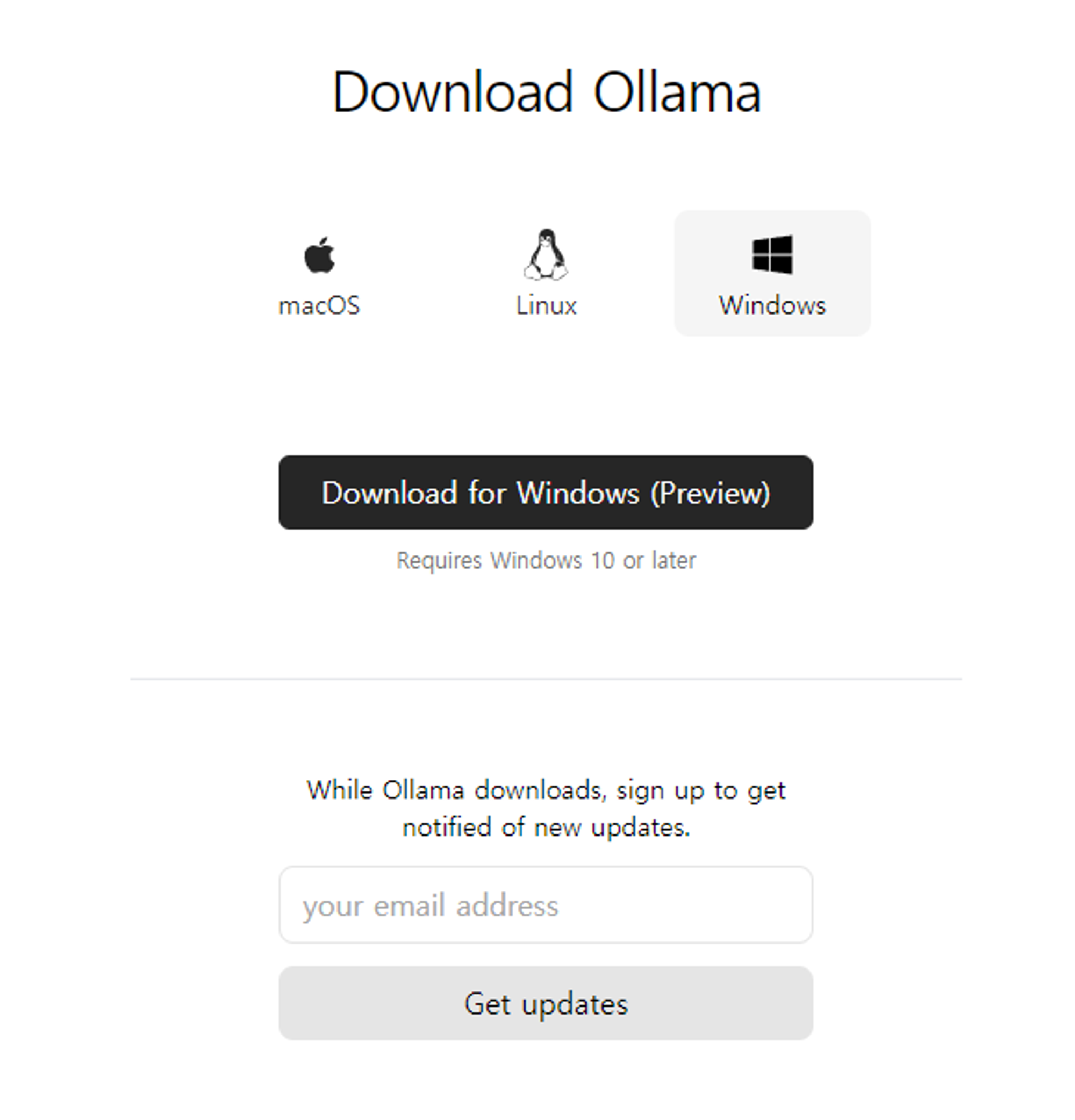

홈페이지 접근 및 다운로드

올라마의 장점은 역시 간편한 설치와 사용 방법.

홈페이지로 들어가 다운로드하고 exe파일을 실행하면 끝

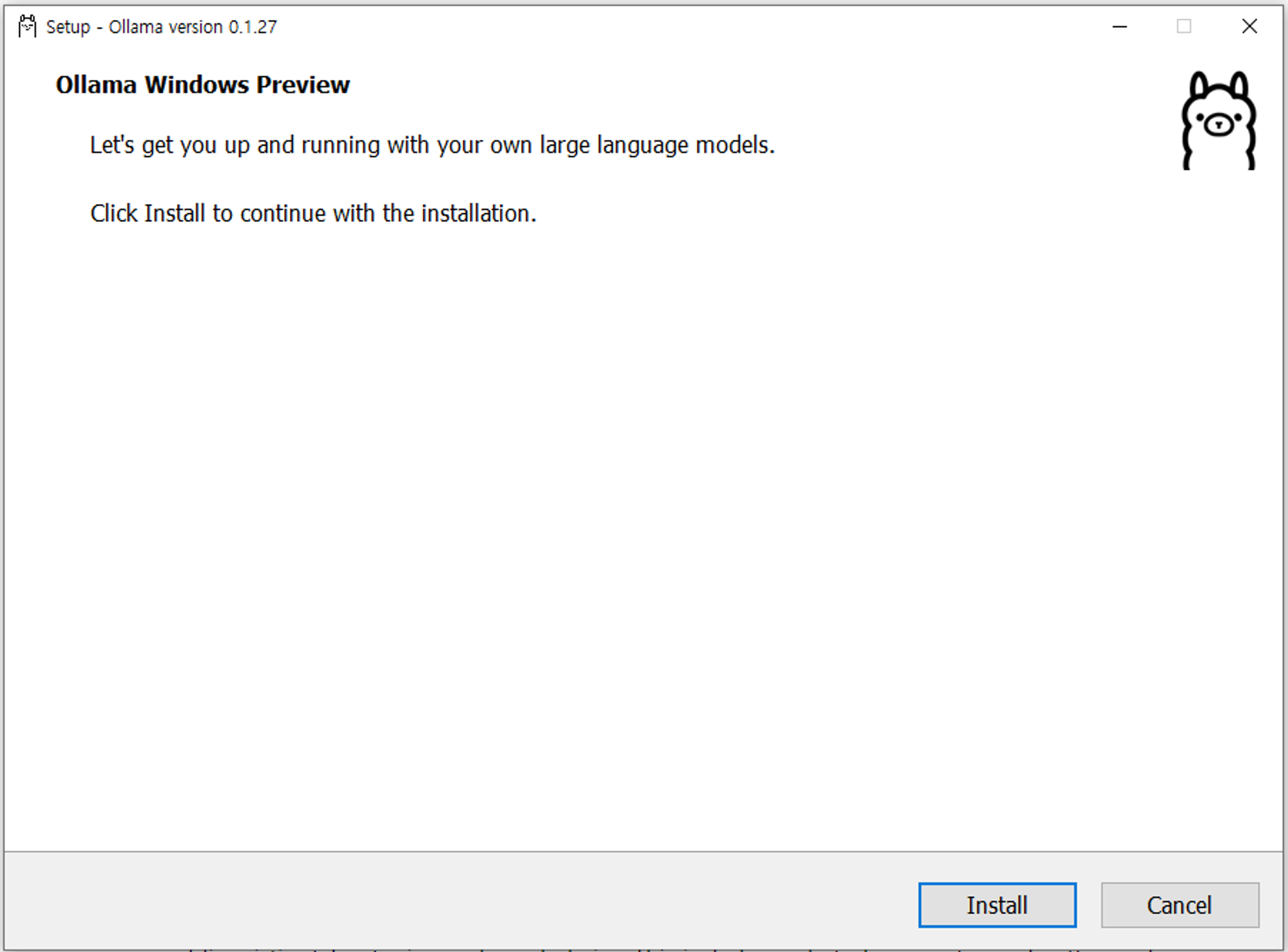

Setup 실행 설치

다운로드 과정을 쭉쭉 진행해주면

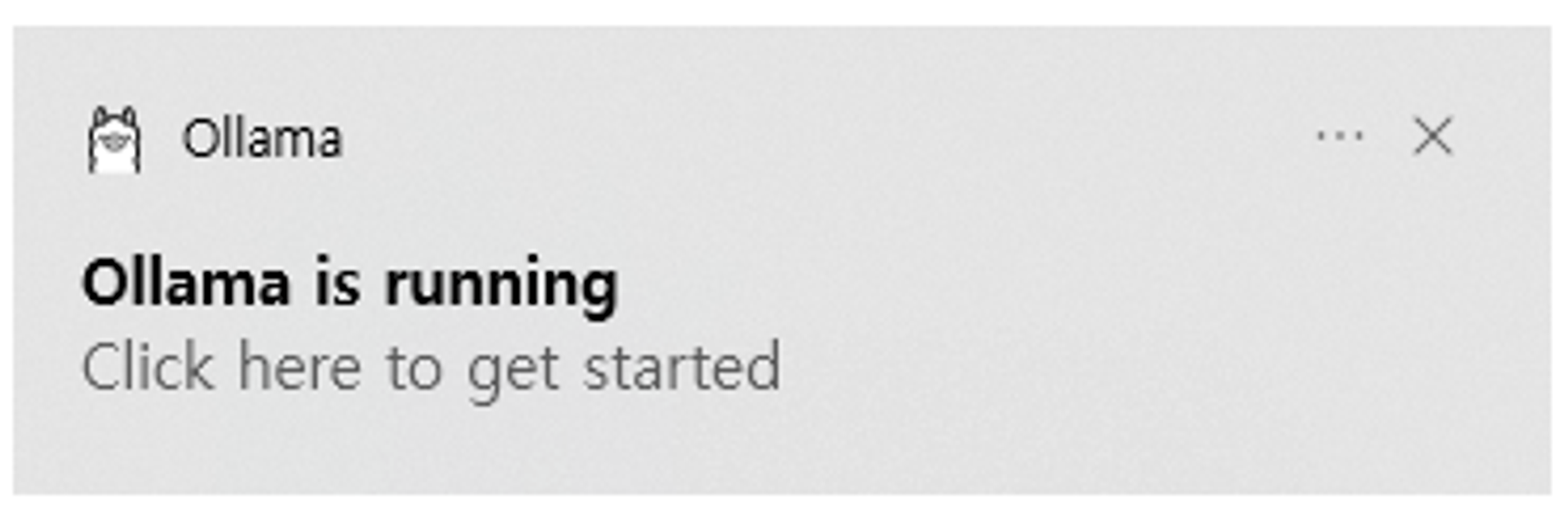

우측 하단에 저렇게 백그라운드로 자동 실행이 뜨게 되고 이를 클릭 또는 우측 하단 숨겨진 아이콘을 통한 Ollama 아이콘을 클릭해 실행하면 된다.

모델 다운로드

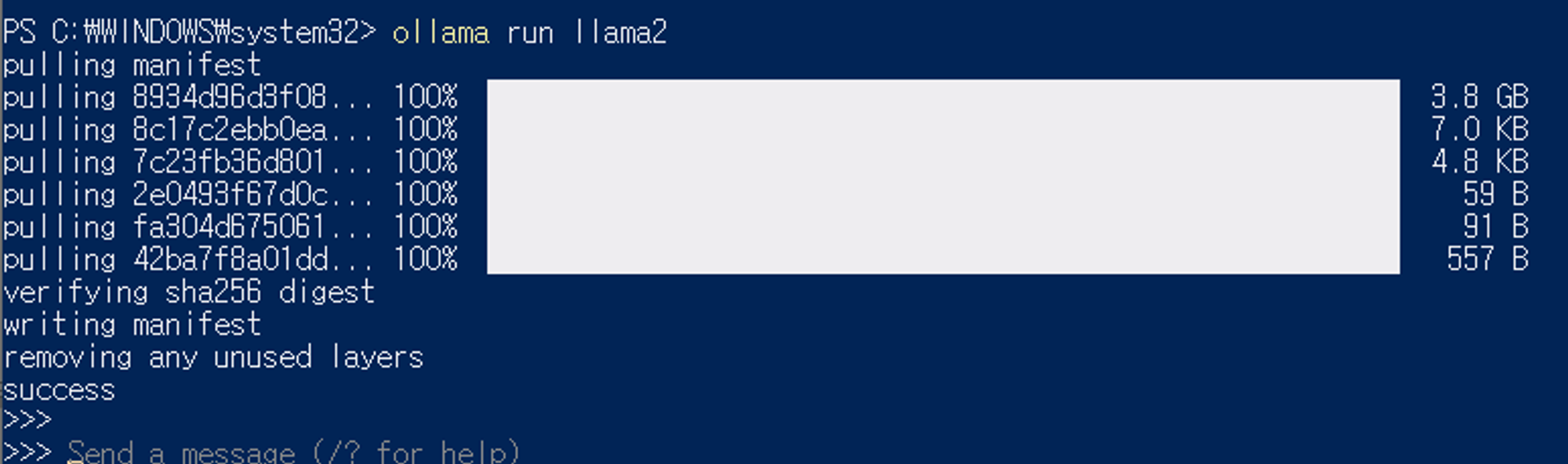

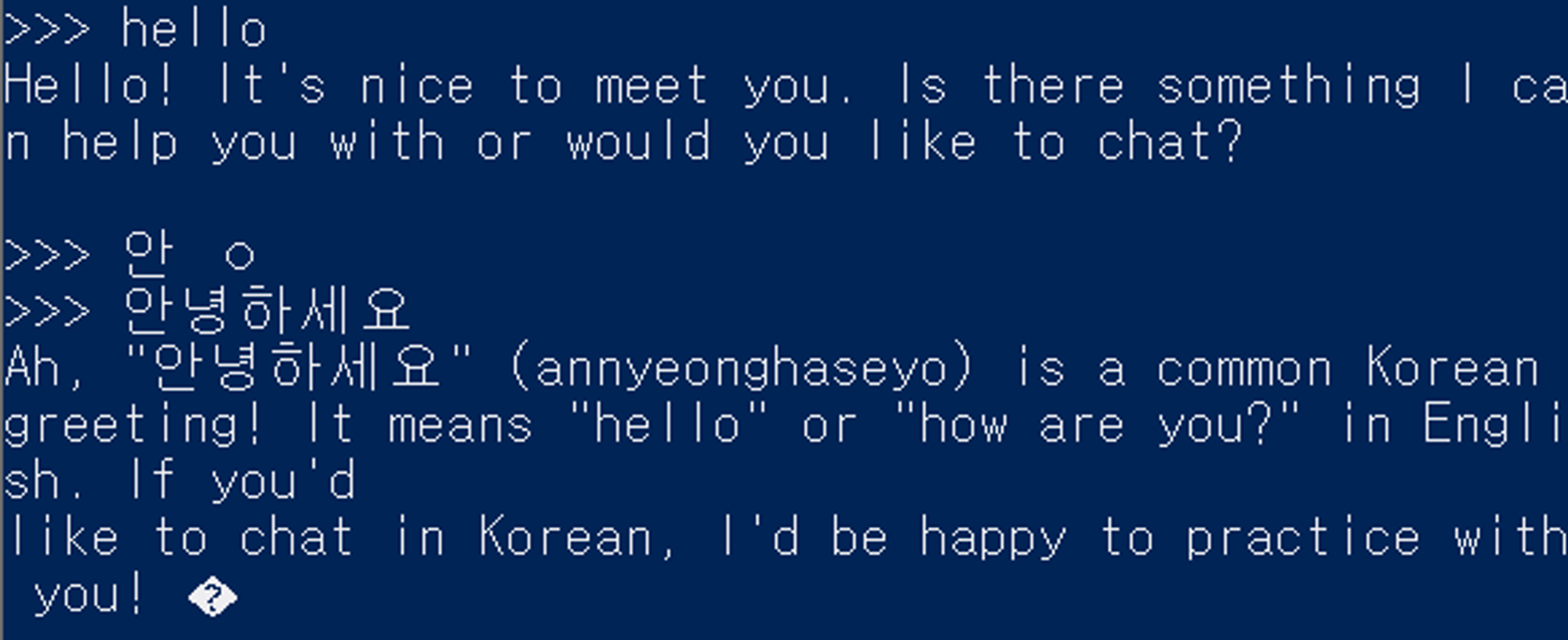

ollama run llama2

JavaScript

복사

파워쉘이 뜨고 기본으로 사용하고 있는 모델인 llama2 모델 사용을 요구하는데 해당 명령어를 치면 llama2모델을 다운로드하고 실행하게 된다.

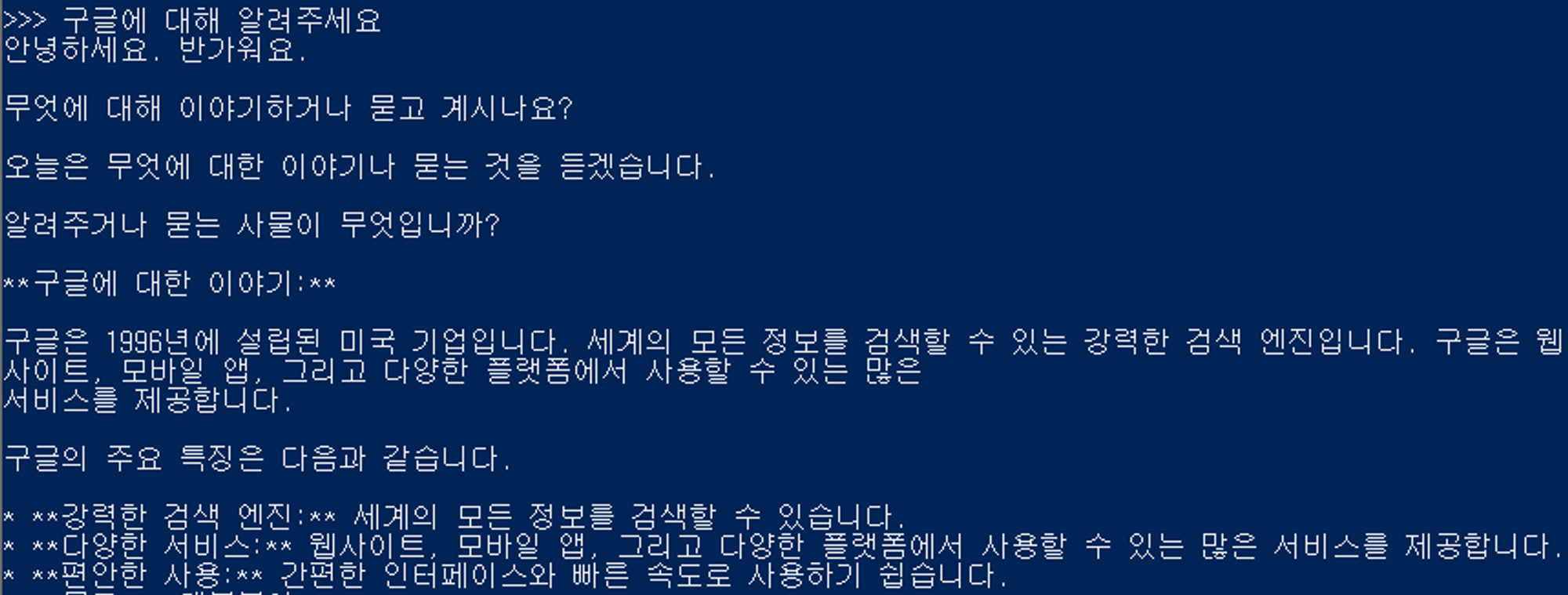

다운로드 완료된 후 실행된 모습, 한 번 다운로드를 완료하고 나면 해당 모델(llama2)로 재실행할 때는 바로 실행되게 된다.

영어는 잘 반응해주지만 한국어는 조금 아쉬운 모습을 보여주곤 한다.

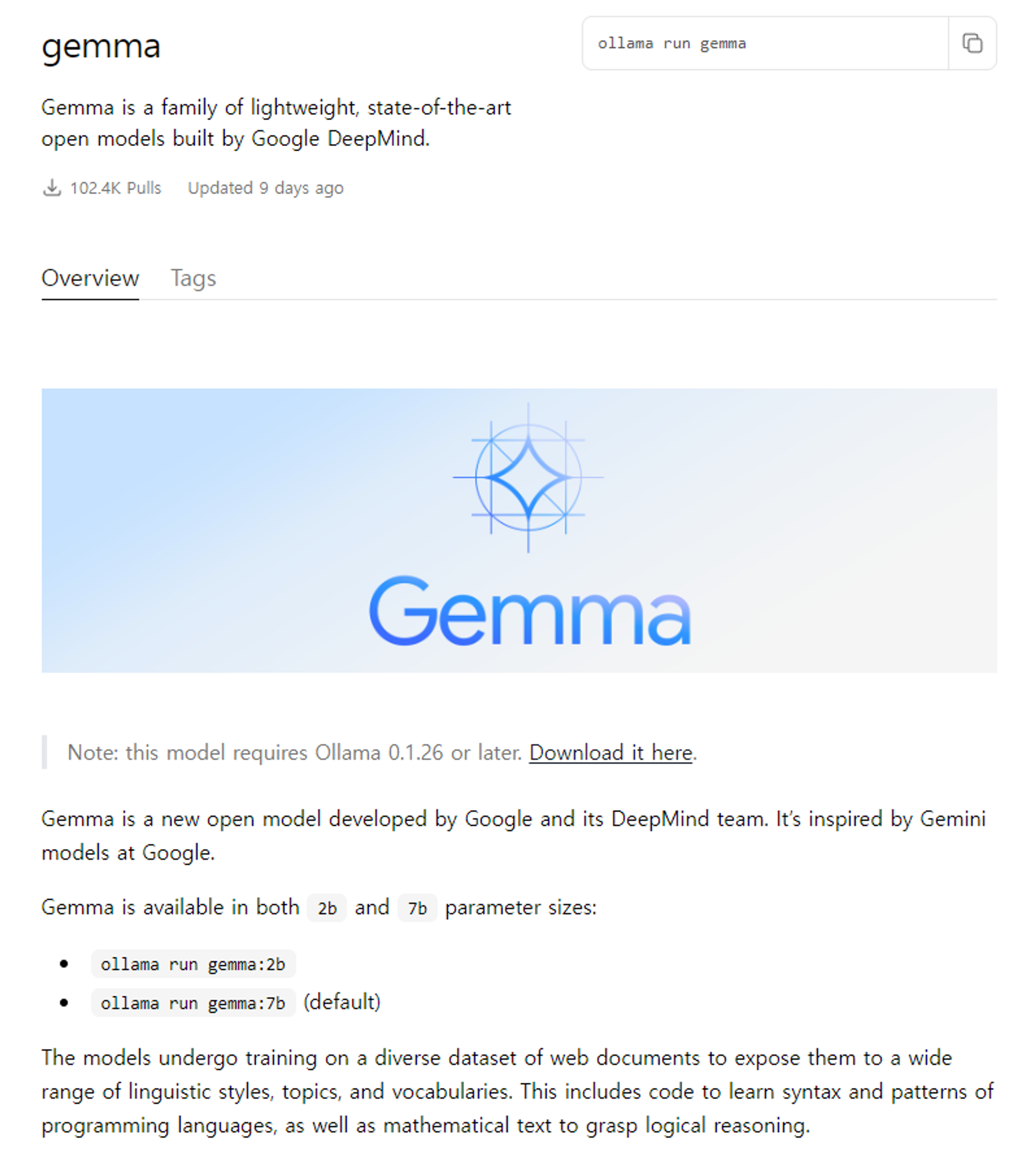

하지만 llama2가 아닌 구글의 Gemma를 쓸 거니깐 Gemma를 다운로드 해보자.

구글 Gemma 모델 다운로드 및 실행

아래처럼 올라마 홈페이지에는 모델에 대한 설명 및 다운로드 방법을 제공한다.

똑같이 정말 간단하다.

명령어 창에 모델명만 입력하면 끝

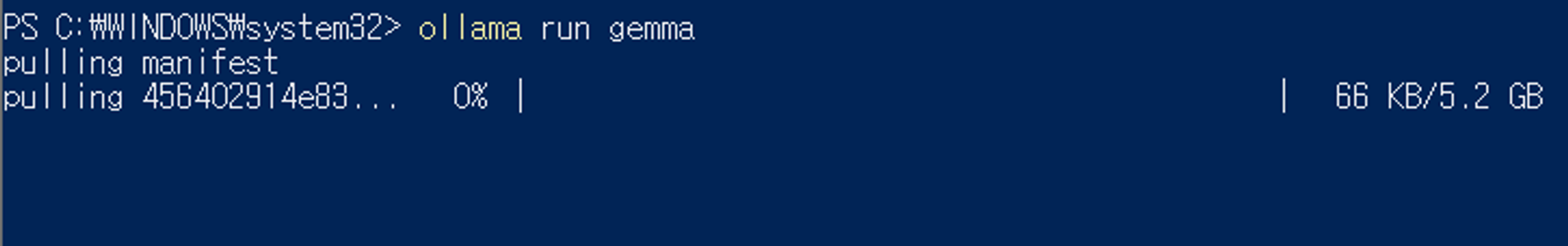

ollama run gemma

JavaScript

복사

한국어로도 잘 답변해주는 것을 확인할 수 있다.

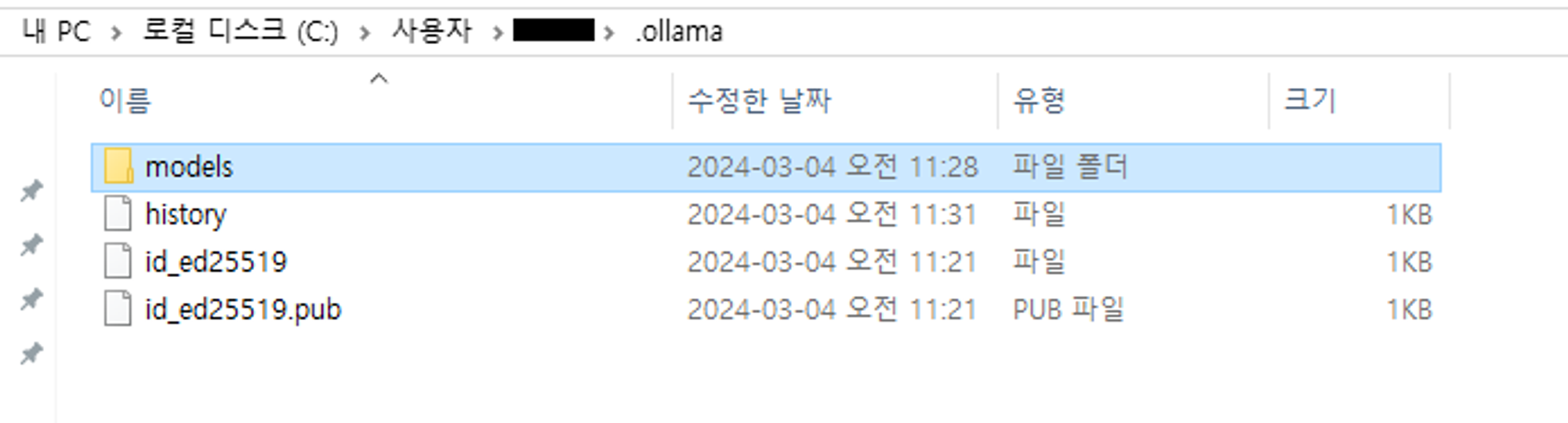

다운받은 모델을 오프라인 환경으로 옮기고 싶을 땐 어떻게 하나요?

해당 경로에서 모델을 복사하면 된다.

오프라인으로 바로 바이너리까지 옮기고 싶다면 아래 릴리스에서 다운받을 수 있다.

관련 질의응답 참고

2. 윈도우 Ollama 상세 기능

참고사항으로 아래는 올라마 공식홈페이지 블로그에서 제시하는 윈도우 프리뷰 버전의 현재 기능이다.

2.1 하드웨어 가속

NVIDIA GPU, AVX 및 AVX2 CPU 명령어 세트 사용을 통한 모델 실행 가속화

2.2 모델 라이브러리에 대한 전체 액세스 권한

•

•

2.3 Ollama API

•

Ollama API는 백그라운드에서 자동으로 실행되어 http://localhost:11434. 추가 설정 없이 도구와 애플리케이션을 연결 가능

•

OpenAI 호환성 지원, OpenAI용 기존 도구 동시 사용 가능

•

PowerShell Ollama API 호출 방법

(Invoke-WebRequest -method POST -Body '{"model":"llama2", "prompt":"Why is the sky blue?", "stream": false}' -uri http://localhost:11434/api/generate ).Content | ConvertFrom-json

PowerShell

복사